ADHOC - Astrophysical Data HPC Operating Center

Il data center ADHOC fa parte di un più ampio progetto, denominato STILES (Strengthening the Italian Leadership in ELT and SKA), relativo ad un'iniziativa finanziata dal Programma Nazionale di Ripresa e Resilienza (PNRR) che mira a rafforzare la leadership italiana nell'esplorazione dell'Universo.

L'obiettivo principale del progetto STILES è lo sviluppo di laboratori e strumenti per i due più grandi telescopi terrestri dei prossimi decenni, l'European Extremely Large Telescope (E-ELT) e lo Square Kilometer Array (SKA), oltre che per altri progetti astrofisici nazionali ed internazionali.

Coordinato dall'Istituto Nazionale di Astrofisica (INAF) in collaborazione con sette università italiane (Università di Bologna "Alma Mater Studiorum"; Università di Milano; Università di Napoli "Federico II"; Università di Palermo; Università di Roma "La Sapienza"; Università di Roma "Tor Vergata"; Università di Catania), il progetto STILES si propone di:

- Investire in tecnologie dell'informazione, acquisendo infrastrutture hardware e software essenziali per lo sviluppo di nuovi strumenti e l'analisi dei dati, inclusi un centro di calcolo ad alte prestazioni e strumenti software basati AI;

- Creare infrastrutture nazionali per la verifica della strumentazione, offrendo servizi generali e strutture polivalenti per la caratterizzazione di strumenti e metodologie innovative;

- Implementare un programma scientifico ed educativo unico, comprendente dottorati e programmi post-dottorato focalizzati sulla scienza con ELT, SKA e le loro sinergie con altri strumenti osservativi internazionali, al fine di sostenere la carriera di giovani ricercatori.

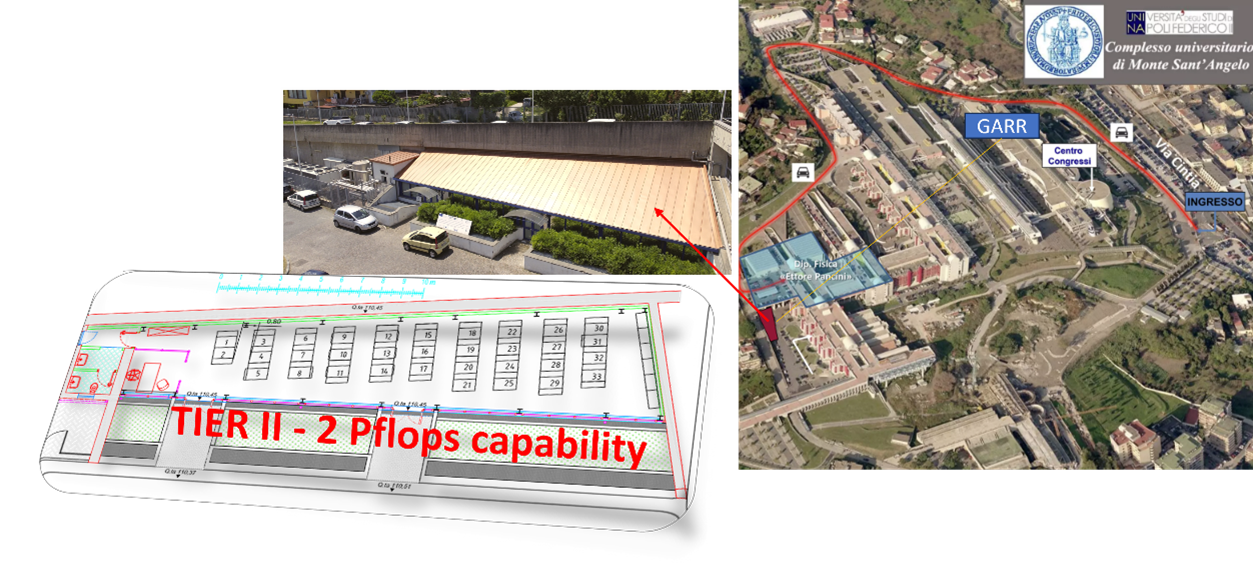

Localizzazione del data center ADHOC all'interno del Complesso Universitario di Monte Sant'Angelo

Risorse e Servizi

ADHOC è un'infrastruttura di calcolo di classe Tier 2, integrata in un pre-esistente centro di calcolo, denominato DC1, con una capacità di calcolo a regime di 2 Petaflops, dotata di:

- un sistema di storage totale di 20 Petabytes (PB) "raw", suddivisi in due sistemi: (i) 8 PB di storage a lungo termine su nastro (due unità, rispettivamente, da 6 PB dislocata presso il centro di elaborazione dati della sede INAF di Bologna, e da 2 PB presso il DC1); (ii) 12 PB di storage "caldo" su dischi, suddiviso in 4 unità logiche da 3 PB ciascuno e gestiti da server front-end dedicati;

- un sistema di calcolo, suddiviso in due sottosistemi, rispettivamente, HPC (High Performance Computing) e HTC (High Throughput Computing), suddivisi logicamente in tre cluster modulari di diversa taglia. Il sistema HPC annovera n° 34 servers bi-processore, di cui 22 dotati di doppia scheda GPU H100 e 12 di doppia scheda GPU L40, dedicato a calcolo parallelo ad alte prestazioni. Il sistema HTC include n° 10 server bi-processore, dedicati al calcolo multi-processing (MPI) e in parte alla gestione e interfacciamento dei vari dispositivi costituenti l'intera infrastruttura. Altri 3 servers HTC/HPC addizionali sono invece scorporati dai cluster e dedicati a progetti e servizi specifici.

- un sistema di rete dati e monitoraggio, connesso su linea ridondata a 10 Gb/s al nodo GARR del CSI (Centro di Ateneo per i Servizi Informatici), sito nel medesimo Complesso universitario. L'architettura di rete dati è composta da varie sotto-reti, rispettivamente, a 10/25 Gb/s per l'interfacciamento con l'esterno e la gestione/monitoraggio dell'infrastruttura, a 100 Gb/s per l'interfacciamento con il sistema storage e HTC, a 200 Gb/s per le connessioni infiniband con il sistema HPC.

Dal punto di vista funzionale, il data center ADHOC si compone di tre cluster di risorse di calcolo e storage, di dimensioni variabili, destinate ad un utilizzo incrementale e differenziato. I tre cluster sono denominati newton, fermi ed einstein, e si riferiscono, rispettivamente, ai tre cluster di taglia piccola, media e grande.

I cluster sono equipaggiati con strumenti avanzati per la gestione e l'ottimizzazione delle risorse:

- Gestione utenti e autenticazione con FreeIPA;

- Scheduler di job SLURM per l'allocazione efficiente delle risorse;

- Computazione parallela con OpenMPI;

- Accelerazione su GPU NVIDIA di diversa taglia e capacità computazionale;

- Filesystem condiviso basato su diversi protocolli;

- Supporto per Python e librerie scientifiche per analisi dati e simulazioni.

Il Team

Coordination and Management

System Administration

Security and Networking Consultance

- Dr. Davide Michelino

- Dr. Bernardino Spisso

The Team also includes several collaborators with experience and scientific and engineering background in the fields of AI, data science, Astrophysics and ICT.

Accesso e Supporto

L'accesso ai servizi ed alle risorse offerte dal data center è possibile tramite la compilazione e trasmissione di un form online ed è regolamentato da una specifica policy di utilizzo.

- Documento di Policy

- Modulo online di richiesta di accesso ai servizi

- Per informazioni e richieste: astroservice@unina.it